Cosa ha scoperto Timnit Gebru?

I rischi dei language models utilizzati da Google, a partire dalla - grossa - notizia che riguarda il licenziamento di una ricercatrice del campo dell'AI.

Nel mondo dell’intelligenza artificiale quando si deve raccontare un esempio di bias nel machine learning si evoca la storia nefasta di quel giorno in cui il riconoscitore automatico di Google Photo scambiò il volto di una ragazza afro-americana per quello di un gorilla. Era il 2015, che in termini informatici è un’era fa e quell’episodio dimostrò il rischio di convivere con dei sistemi intelligenti affetti da bias razziali. Fu un piccolo scandalo che costrinse la società di Mountain View ad ovvie scuse e una promessa di correggere l’errore in tempi brevi. Nel 2018 Google aveva rimosso le label “gorilla”, “scimmia”, “scimpanzé” (e le restanti che rimandano ai primati) ma effettivamente il problema non era stato risolto. I tre anni passati solamente per ottenere un workaround applicato dagli sviluppatori manifestava non solamente la difficoltà di risolvere i difetti dei modelli di riconoscimento considerati robusti ed efficienti ma palesava l’esistenza di bias provocati dalla sottorappresentazione dei gruppi etnici. L’underrepresentation è stato uno dei primi casi di bias che evidenziano con chiarezza che i modelli intelligenti potevano essere - a loro insaputa - razzisti.

Per chi non avesse nessuna base riguardante il concetto generale di bias (in campo informatico) sarebbe esaustiva l’intervista di Alessandro Isidoro Re e Francesca Monica Colombo a Diletta Huyskes nella quale si toccano temi centrali dell’articolo che state leggendo e che può essere di supporto.

Da quel 2015 l’impressione è che la questione etica nel campo delle AI sia diventata sempre più urgente ma ancora complessa se messa in relazione ai giochi di potere ed economici che riguardano i grandi monopoli della tech industry.

Uscite editoriali come Algorithms of Oppression di S. U. Noble, The Age of Surveillance Capitalism di S. Zuboff , Race After Technology di R. Benjamin o del da poco tradotto Il futuro migliore: in difesa dell’essere umano. Manifesto per un ottimismo radicale di P. Mason sono solo alcuni dei saggi che riguardando la tech ethics e che interessano e appassionano la comunità.

Nelle ultime ore il nome di Timnit Gebru, co-leader del team dell'ethical team di Google, è finito sulle prime pagine delle riviste di tecnologia più attente alle questioni etiche e politiche.

La storia della ricercatrice è interessante: nasce in Etiopia da genitori eritrei, ma da ragazzina emigra prima in Irlanda, poi negli USA; a Stanford si laurea specializzandosi in ingegneria elettrica ed esordisce nel mondo del lavoro con Apple, partecipando allo sviluppo del primo iPad. Ma dal dottorato in poi gli studi si concentrano su data mining e sulla data collecting, ovvero sui processi di raccolta e misurazione dei dati, in relazione allo studio delle comunità locali statunitensi.

“Using deep learning and Google Street View to estimate the demographic makeup of neighborhoods across the United States” è il nome di uno dei suoi paper più sorprendenti da un punto di vista teorico e di conclusioni. Scritto a più mani, obiettivo della tesi è la dimostrazione delle differenze di ceto, etnia, educazione e altre caratteristiche di una comunità che possono essere dedotte dalle automobili geolocalizzate in una data area abitativa. Ai fini squisitamente di discrezione intellettuale diremo che una città con una maggiore percentuale di berline voterà democratica, mentre una con maggioranza di pick-up voterà repubblicana.

Sembrerà una stupidata, ma giungere a una conclusione del genere e poter dire che il servizio Google Street View può essere utile ad analizzare le disuguaglianze sociali di un Paese è stato qualcosa di grosso. Per la ricerca furono utilizzate qualcosa come 50 milioni di immagini di 200 città diverse. La distribuzione del tipo di autoveicoli nella stessa città, come nel caso della ultra-conservatrice Jacksonville, evidenziano le disuguaglianze sociali tra quartieri. Un modello di machine learning era quindi in grado di poter predire, a seconda delle foto geolocalizzate di automobili, le condizioni di precarietà di un zona rispetto ad un’altra.

“How to stop Artificial Intelligence From Marginalizing Communities” è il nome di una presentazione Ted fatta da Gebru mentre era collaboratrice di Microsoft, nella quale espone i rischi dei modelli di predizioni di crimini urbani, dei sistemi intelligenti in grado di ipotizzare il numero di anni di carcere che dovrebbe ricevere un colpevole di reato, o del riconoscimento automatico di soggetti come possibili terroristi. A volte gli errori possono essere perfino ridicoli, come quel giorno che Israele arrestò un palestinese perché Facebook aveva tradotto un “Good Morning” in “Attack Them.”

Negli ultimi giorni i video disponibili su youtube dedicati alla figura di Gebru stanno registrando un aumento di visualizzazioni: “Who is here after she got SACKED from Google?”, scrive un utente sotto il video della presentazione Ted.

La notizia è fresca e sta sconvolgendo la scena che si interessa di etica e tech: Timnit Gebru ha interrotto la sua collaborazione con Google in qualità di co-leader del settore AI ethics research. Una rottura lenta, passata tra tweet infuocati, che è divenuta definitiva nel momento in cui Gebru ha presentato una serie di paper piuttosti compromettenti nei confronti del management di Google nel campo del machine learning e ai modelli linguistici.

Ad oggi sappiamo che Gebru è stata, secondo la sua testimonianza, licenziata via email senza preavviso. Il MIT Technology Review è riuscito ad ottenere i paper della ricercatrice, la mela della discordia nei confronti della dirigenza di Google. Alla redazione i fogli sono stati inviati da Emily Bender, professoressa di linguistica computazionale alla University of Washington e co-autrice della ricerca. Il paper, che si chiama “On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?”, ha un’introduzione dedicata alla nascita e l’evoluzione del Natural Language Processing (NLP), in italiano conosciuto come Elaborazione del Linguaggio Naturale.

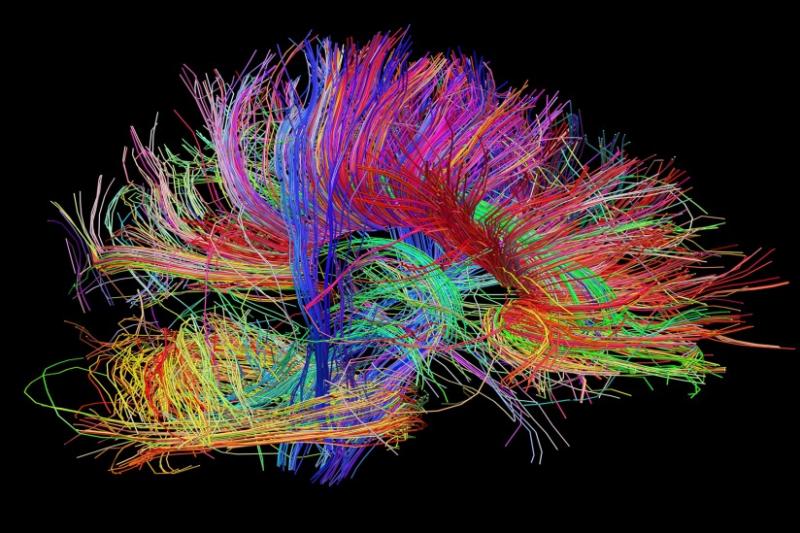

L’NLP è l’insieme delle tecniche che si utilizzano per far apprendere a un sistema informatico il linguaggio scritto e parlato, tramite processi di analisi semantica, sintattica e grammaticale. Negli ultimi anni il Deep Learning e le più potenti librerie di Machine Learning hanno incentivato e accelerato la disciplina, che negli assistenti conversazionali come Siri o Alexa ha trovato un impiego popolare. Lo stato dell’arte dell’NLP a Google è BERT (Bidirectional Encoder Representations from Transformers), creato sulla base di un sofisticato modello di Deep Learning; BERT si pone come un framework, in grado di soddisfare una vasta serie di compiti, come la sentiment analysis o la named entity recognition (il riconoscimento di entità, come possono essere nomi di persona, città, etc), completamento automatico di una frase o classificazione di un testo (potrebbe riconoscere il genere di un romanzo).

I modelli di NLP, come tutti quelli di Machine Learning, per essere creati vanno allenati: bisogna raccogliere una gran quantità di dati per poi “darli in pasto” alla funzione che genere un modello. Quest’ultimo viene creato durante una lunga fase di training, durante la quale i dati vengono analizzati, codificati e computati passando per complesse funzioni matematiche. Più il dataset di allenamento è grande e più ci sarà bisogno di step di allenamento, detti epoche.

Il processo, quando si parla di milioni di dati, è costoso anche a livello energetico. Negli studi di Gebru il costo è aumentato terribilmente dal 2017 in carbon footprint, il parametro che si utilizza per calcolare la quantità di gas serra emanati da un processo o un prodotto. Giusto per dare due numeri: un anno di vita umana costa circa due tonnellate di CO2 (non negli USA, lì si sale verso le venti), mentre un Transformer - che è un modello di Deep Learning - basato su 200 milioni di dati di input, con la sua architettura neurale, costa circa 283 tonnellate di CO2.

È già di per sé per un dato rilevante, ma la cosa diventa emergenziale perché un modello, durante una fase di ricerca e sviluppo, viene riprodotto più volte.

Chiuso il capitolo energetico se ne apre un altro, quello della discriminazione. I training set anche per comodità vengono creati raccogliendo frasi, con tecniche per lo più automatizzate e di scraping, da Internet. Senza nessuna forma di vincoli nel codice e algoritmi finalizzati, il modello impara senza saper discriminare forme di razzismo scritto.

Gebru e il resto della squadra si chiedono quando e come approcciare a livello algoritmo un Internet che è stato invaso, a livello di discussione, dalle tematiche Black Lives Matters o MeeToo. Non è oggi possibile affidarsi a un dataset figlio di un assimilazione vasta e generalista, senza sfumature studiate a tavolino a lato programmazione. Il timore degli autori del paper è che i modelli si perderanno per forza di cose gli impegni e le battaglie svolte dai gruppi di protesta. Altra problematica che si è posta Gebru e il suo team è quella riguardante tutte le culture minoritarie, che a livello linguistico non lasciano tracce - nella rete - tante quanto lo fanno quelle dominanti. Quello che può essere un overfitting o una vera e propria esclusione testuale, troppi parametri da una parte e troppi pochi dall’altra, non fanno che produrre modello omogenei e centralizzati dalle culture dominanti: ad oggi quelle ricche e bianche. Se a leggerlo non vi sembra grave e complessa la situazione vi basti ricordare la storia del gorilla ad inizio articolo: i modelli robusti richiedono un costo anche teorico, ogni bias richiede una lunga analisi.

Terzo punto critico del paper è sul processo di affinamento dei modelli. I computer, quindi i modelli di intelligenza, non capiscono il linguaggio ma lo manipolano. La potenza economica dei re Mida del tech della Silicon Valley permette loro di riprocessare interi modelli da zero, dimenticando o mettendo da parte le questioni energetiche. Gebru propone un nuovo approccio, più artigiano e di fino: modelli più piccoli, operazioni di tweaking focalizzate, spendere meno.

Infine, i modelli di intelligenza artificiale rischiano, migliorando sempre di più, di diventare fonte di fake news e manipolazione della percezione del mondo.

Il paper riassunto dal MIT Review avrebbe ricevuto pubblicazione nel 2021, ma prima ha girato interamente a Google in un contesto formale e prassi di revisione. I dirigenti hanno chiesto il ritiro dell’articolo ma Gebru ha contrattacco chiedendo spiegazioni e approvazione del paper, la quale, coerentemente, avrebbe minacciato l’interruzione del rapporto lavorativo con l’azienda.

Nel mentre Gibru scriveva una lettera nella quale Google veniva accusata di essere ancora poco attenta nella questione di genere e delle minoranze, evidenziando, “ho visto la mia esperienza completamente ignorata.”

Google si comporta come una vecchia monarchia restauratrice: è un casus belli che gli permette di licenziare la dottoressa Gibru via mail. Qualche giorno dopo il contatto aziendale viene eliminato e in contemporanea cominciano a levarsi voci in supporto della ricercatrice.

Twitter intanto si trasforma in un campo di battaglia tra figure più o meno grosse di Google. Jeff Dean, capo dell’intero reparto di Intelligenza Artificiale, scrive che la ricerca di Gibru è debole e presentava dei gap che non superano la review interna; al quale risponde William Fitzgerald, ex PM manager, con “This is such a lie. [...]”.

Standing with Dr. Timnit Gebru è il nome della petizione a sostegno della ricercatrice, che ha raccolto le firme, ad oggi, di più di 2000 dipendenti di Google e 3000 accademici. La firma dei dipendenti della casa di Mountain View vale due volte: non c’è solamente riconoscenza e considerazione del lavoro di Gebru, ma è l’evidenza di un’insoddisfazione politica che esiste anche nel cuore pulsante di Google. “Don’t Be Evil” era l’antico motto dell’azienda, rimosso cinque anni fa. Sono in molti da quelle parti che ancora non l’hanno dimenticato.